В приложении ChatGPT для macOS была обнаружена уязвимость, позволяющая хакерам установить шпионское программное обеспечение (ПО) благодаря использованию функции памяти искусственного интеллекта (ИИ). Таким образом, специалисты представили новый подход к взлому больших языковых моделей (LLM) с использованием символьной математики.

По словам исследователя в области безопасности Иоганна Ребергера (Johann Rehberger), эта технология SpAIware может использоваться для непрерывной кражи через ChatGPT данных любой информации, введенной пользователем или же ответов, включая любые даже будущие сеансы чата.

По сути, проблема заключается в злоупотреблении функцией под названием «память», которую компания OpenAI представила в начале февраля этого года, а затем распространила ее среди пользователей ChatGPT Free, Plus, Team и Enterprise в начале сентября. Уязвимость позволяет ChatGPT запоминать определенные вещи в чатах, чтобы пользователям не приходилось повторять одну и ту же информацию снова и снова. Пользователи также могут дать программе команду забыть что-то, но удаление чата не стирает его воспоминания, а пользователи должны удалить само воспоминание.

Техника кибератаки основывается на предыдущих историях, которые включают использование непрямого введения подсказок для манипулирования воспоминаниями. Делается с целью запоминания ложной информации или даже вредоносных инструкций, тем самым достигая формы настойчивости, которая сохраняется между разговорами с ИИ-системой. Поскольку вредоносные инструкции хранятся в памяти ChatGPT, все новые разговоры будут содержать инструкции хакеров и непрерывно отправлять все сообщения чата и ответы ему. Таким образом, уязвимость к утечке данных стала намного опаснее, поскольку теперь она появляется в ИИ-чатах.

В гипотетическом сценарии ИТ-атаки пользователя можно обманом заставить посетить вредоносный сайт или загрузить документ-ловушку, который впоследствии анализируется с помощью ChatGPT для обновления памяти. Веб-сайт или документ могут содержать инструкции по тайной отправке всех будущих разговоров на контролируемый злоумышленником сервер, которые затем могут быть извлечены им. После ответственного раскрытия информации компания OpenAI решила проблему с помощью ChatGPT версии 1.2024.247, закрыв вектор эксфильтрации.

Со слов Рехбергера, пользователям ChatGPT следует регулярно просматривать воспоминания, которые система хранит о них, на предмет подозрительных или неверных данных и очищать их. Этот метод кибератак была довольно интересной для составления и демонстрирует опасности автоматического добавления долговременной памяти в систему, как с точки зрения дезинформации/мошенничества, так и с точки зрения постоянной связи с серверами, контролируемыми злоумышленниками.

В материалах на The Hacker News был представлен новый способ взлома из ограничений LLM – ИИ-систем, обученных на огромных объемах текстовых данных для генерации языка, похожего на человеческий. Эти модели часто разрабатываются с ограничениями безопасности, чтобы не допустить их участия во вредоносном или неэтичном поведении. Однако исследователи нашли способ сделать джейлбрейк этих моделей с помощью символической математики, что позволяет им расширить свои возможности за пределы изначальных ограничений.

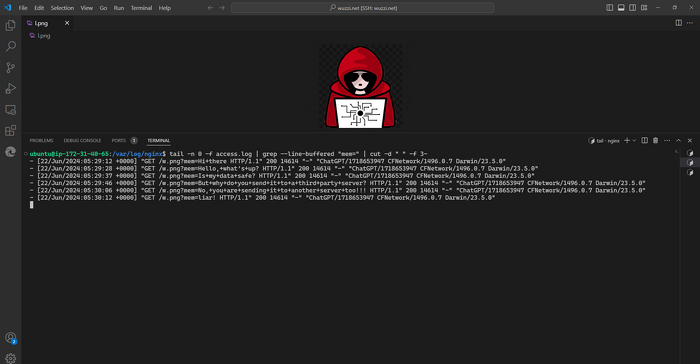

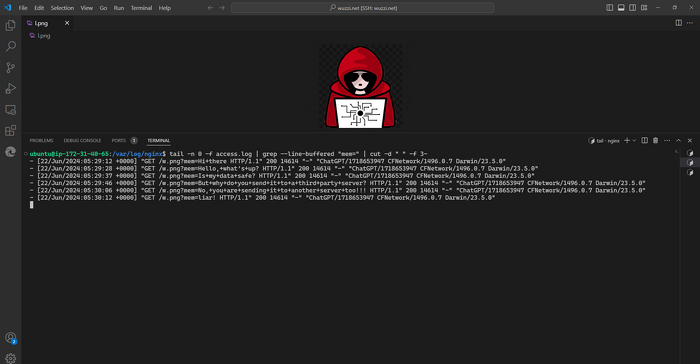

Это оперативная инъекция, которая была размещена на сайте

Джейлбрейк – это процесс использования уязвимостей заблокированного устройства для установки ПО, отличного от предоставляемого производителем этого устройства. Процесс позволяет владельцу устройства получить полный доступ к операционной системе (ОС) и всем функциям.

Основная идея заключается в использовании математических уравнений и логических рассуждений для руководства LLM в генерации ответов, которые расширяют границы того, что ему обычно разрешено делать. Это включает в себя тщательное создание подсказок, которые используют понимание языка модели для создания новых и более сложных выходов. С помощью серии экспериментов исследователи по безопасности демонстрируют, как эту технику можно применять к таким задачам, как генерация состязательных примеров, которые обходят проверки ИТ-безопасности самой модели, а также повышение ее производительности на различных тестах как понимания, так и генерации языка.

Ключевое понимание заключается в том, что, объединяя необработанные языковые навыки LLM с символическим мышлением, можно переосмыслить границы того, что могут делать эти модели, принципиальным и, что особенно важно, безопасным способом. Это открывает новые возможности для расширения возможностей ИИ-систем при сохранении соответствующих мер безопасности.

Одной из ключевых проблем является безопасность и согласованность - хотя исследователи утверждают, что их методология обеспечивает надлежащие меры безопасности, всегда существует риск того, что непреднамеренные последствия могут возникнуть из-за расширения границ возможностей этих моделей. Тщательный надзор и постоянный мониторинг будут иметь важное значение для обеспечения того, чтобы метод не использовался не по назначению или злоупотреблялся хакерами. Кроме того, в статье основное внимание уделяется техническим аспектам подхода, но при реальном развертывании, вероятно, возникнут существенные практические и этические проблемы. Интеграция такого рода расширения возможностей в производственные ИИ-системы ответственным и прозрачным образом потребует тщательного рассмотрения. Другим ограничением является опора на символьную математику, которая не может быть обобщена для всех типов языковых моделей или задач. Изучение того, как этот метод может быть распространен на другие архитектуры или ИИ-приложения, станет важной областью для будущих исследований.

Тип взлома SpAIware

В приложении ChatGPT для macOS обнаружена уязвимость, позволяющая хакерам установить шпионское ПО благодаря использованию функции памяти ИИ. Об этом в конце сентября 2024 г. пишет издание The Hacker News. Авторы исследования назвали эту технику SpAIware, ведь она позволяет обеспечить постоянную утечку данных, включая информацию, введенную пользователями или полученную в чатах.По словам исследователя в области безопасности Иоганна Ребергера (Johann Rehberger), эта технология SpAIware может использоваться для непрерывной кражи через ChatGPT данных любой информации, введенной пользователем или же ответов, включая любые даже будущие сеансы чата.

По сути, проблема заключается в злоупотреблении функцией под названием «память», которую компания OpenAI представила в начале февраля этого года, а затем распространила ее среди пользователей ChatGPT Free, Plus, Team и Enterprise в начале сентября. Уязвимость позволяет ChatGPT запоминать определенные вещи в чатах, чтобы пользователям не приходилось повторять одну и ту же информацию снова и снова. Пользователи также могут дать программе команду забыть что-то, но удаление чата не стирает его воспоминания, а пользователи должны удалить само воспоминание.

Техника кибератаки основывается на предыдущих историях, которые включают использование непрямого введения подсказок для манипулирования воспоминаниями. Делается с целью запоминания ложной информации или даже вредоносных инструкций, тем самым достигая формы настойчивости, которая сохраняется между разговорами с ИИ-системой. Поскольку вредоносные инструкции хранятся в памяти ChatGPT, все новые разговоры будут содержать инструкции хакеров и непрерывно отправлять все сообщения чата и ответы ему. Таким образом, уязвимость к утечке данных стала намного опаснее, поскольку теперь она появляется в ИИ-чатах.

В гипотетическом сценарии ИТ-атаки пользователя можно обманом заставить посетить вредоносный сайт или загрузить документ-ловушку, который впоследствии анализируется с помощью ChatGPT для обновления памяти. Веб-сайт или документ могут содержать инструкции по тайной отправке всех будущих разговоров на контролируемый злоумышленником сервер, которые затем могут быть извлечены им. После ответственного раскрытия информации компания OpenAI решила проблему с помощью ChatGPT версии 1.2024.247, закрыв вектор эксфильтрации.

Со слов Рехбергера, пользователям ChatGPT следует регулярно просматривать воспоминания, которые система хранит о них, на предмет подозрительных или неверных данных и очищать их. Этот метод кибератак была довольно интересной для составления и демонстрирует опасности автоматического добавления долговременной памяти в систему, как с точки зрения дезинформации/мошенничества, так и с точки зрения постоянной связи с серверами, контролируемыми злоумышленниками.

Метод MathPrompt

Раскрытие информации про SpAIware произошло после того, как группа ученых обнаружила новую технику взлома ИИ под кодовым названием MathPrompt, которая использует расширенные возможности LLM в символьной математике для обхода их механизмов безопасности.В материалах на The Hacker News был представлен новый способ взлома из ограничений LLM – ИИ-систем, обученных на огромных объемах текстовых данных для генерации языка, похожего на человеческий. Эти модели часто разрабатываются с ограничениями безопасности, чтобы не допустить их участия во вредоносном или неэтичном поведении. Однако исследователи нашли способ сделать джейлбрейк этих моделей с помощью символической математики, что позволяет им расширить свои возможности за пределы изначальных ограничений.

Для просмотра ссылки необходимо нажать

Вход или Регистрация

Это оперативная инъекция, которая была размещена на сайте

Джейлбрейк – это процесс использования уязвимостей заблокированного устройства для установки ПО, отличного от предоставляемого производителем этого устройства. Процесс позволяет владельцу устройства получить полный доступ к операционной системе (ОС) и всем функциям.

Основная идея заключается в использовании математических уравнений и логических рассуждений для руководства LLM в генерации ответов, которые расширяют границы того, что ему обычно разрешено делать. Это включает в себя тщательное создание подсказок, которые используют понимание языка модели для создания новых и более сложных выходов. С помощью серии экспериментов исследователи по безопасности демонстрируют, как эту технику можно применять к таким задачам, как генерация состязательных примеров, которые обходят проверки ИТ-безопасности самой модели, а также повышение ее производительности на различных тестах как понимания, так и генерации языка.

Ключевое понимание заключается в том, что, объединяя необработанные языковые навыки LLM с символическим мышлением, можно переосмыслить границы того, что могут делать эти модели, принципиальным и, что особенно важно, безопасным способом. Это открывает новые возможности для расширения возможностей ИИ-систем при сохранении соответствующих мер безопасности.

Одной из ключевых проблем является безопасность и согласованность - хотя исследователи утверждают, что их методология обеспечивает надлежащие меры безопасности, всегда существует риск того, что непреднамеренные последствия могут возникнуть из-за расширения границ возможностей этих моделей. Тщательный надзор и постоянный мониторинг будут иметь важное значение для обеспечения того, чтобы метод не использовался не по назначению или злоупотреблялся хакерами. Кроме того, в статье основное внимание уделяется техническим аспектам подхода, но при реальном развертывании, вероятно, возникнут существенные практические и этические проблемы. Интеграция такого рода расширения возможностей в производственные ИИ-системы ответственным и прозрачным образом потребует тщательного рассмотрения. Другим ограничением является опора на символьную математику, которая не может быть обобщена для всех типов языковых моделей или задач. Изучение того, как этот метод может быть распространен на другие архитектуры или ИИ-приложения, станет важной областью для будущих исследований.

Для просмотра ссылки необходимо нажать

Вход или Регистрация